Script initial - extraction en vrac avec numérotation des articles et feuille de transformation XSL avec compteur des doublons

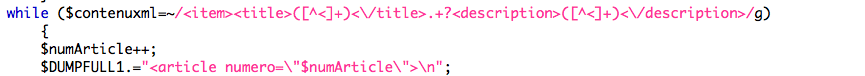

Dans ce script le filtrage se fait avec une expression régulière.

Ce script compte les articles, un moyen qui permet de s'assurer que tous en ont été traités.

Quant à l'encodage, on veut que les sorties TXT soient encodées en ISO-8859-1 et les sorties XML en UTF-8. Or, les fichiers d'entrées sont en ISO-8859-1. On encode les titres et descriptions extraits en utf-8, on les ajoute dans la sortie xml, ensuite on les décode en ISO-8859-1 pour les ajouter dans la sortie txt au cas où il y aurait des fichiers avec d'autres encodages.

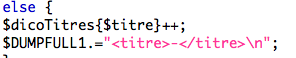

On traite aussi les doublons à l'aide d'un tableau de hachage :

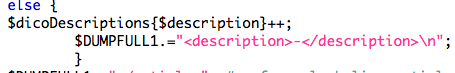

Le nettoyage est fait à la main (merci aux étudiants des années précendentes à qui on a piqué la liste). On l'a testé sur les données de 2008.

Comme résultat, on a un fichier XML et un fichier TXT contenant chacun les titres et les résumés des articles, sans distinction de rubrique. Les sorties par rubrique sont obtenues à l'étape suivante.

Pour télécharger le script initial avec commentaires détaillés, cliquez ici.

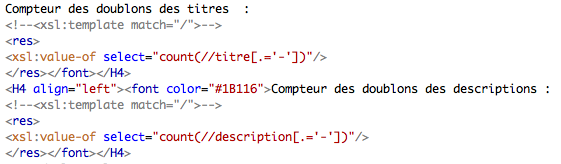

Pour l'affichage des résultats en format XML, nous avons créé une feuille de transformation XSL, dans laquelle nous avons ajouté un compteur des doublons des articles en utilisant une requête XPath.

Finalement, nous avons décidé de ne plus utiliser ce script sur le corpus 2012. Nous avons pourtant une sortie 2008 avec la feuille de style.